L’impiego del guano, escrementi di uccelli con ricco tenore di azoto e fosforo, si sviluppò considerevolmente in Inghilterra e negli Stati Uniti dal 1840. Il suo commercio si prolungò fino al 1875 quando fu rimpiazzato dal nitrato cileno come sorgente di azoto e integrato in parte dal solfato di ammonio ottenuto dalle acque di lavaggio delle officine del gas illuminante.

Un notevole progresso per i concimi azotati venne dato dal metodo Haber, una sintesi diretta di ammoniaca da idrogeno e azoto con un opportuno catalizzatore. Nel 1913 a Oppau in Germania sorse il primo grande impianto con sistema Haber in grado di toccare già le 43.000 tonnellate agli inizi della Prima guerra mondiale.

Il solfato di rame, già usato nelle campagne inglesi, si diffuse rapidamente dopo il 1882, unito a calce come “poltiglia bordolese”, appena venne individuata in Francia la sua efficacia contro la peronospora della vite

Ma il composto di sintesi più innovativo è stato il DDT. Ottenuto da uno studente già nel 1874, solo nel 1939 nei laboratori Geigy ci si accorse della sua attività particolarmente forte e persistente come insetticida. Il DDT venne usato la prima volta a Napoli nel 1943 per bloccare un’epidemia di tifo che aveva prodotto effetti devastanti tra i soldati americani e un anno dopo per combattere efficacemente la malaria.

Dimitrij Mendeleev (1834-1907) preparò la griglia degli elementi lasciandola incompleta perché aveva previsto che sarebbero stati scoperti altri elementi chimici. La sua tavola degli elementi fu volutamente incompleta, e permise di “immaginare” i nuovi elementi.

Ad esempio, l’esistenza di germanio, gallio e scandio fu prevista grazie alla struttura della tavola, che ordina gli elementi per numero atomico (allora ignoto) crescente e per stato di ossidazione crescente a gruppi.

Le applicazioni industriali della chimica diedero il via ad una seconda grande fase dell’industrializzazione, dopo quella incentrata sulla macchina a vapore e sull’industria tessile. La novità principale era costituita dal fatto che si trattava, come per l’elettricità, di un’industria direttamente basata sulle scoperte scientifiche.

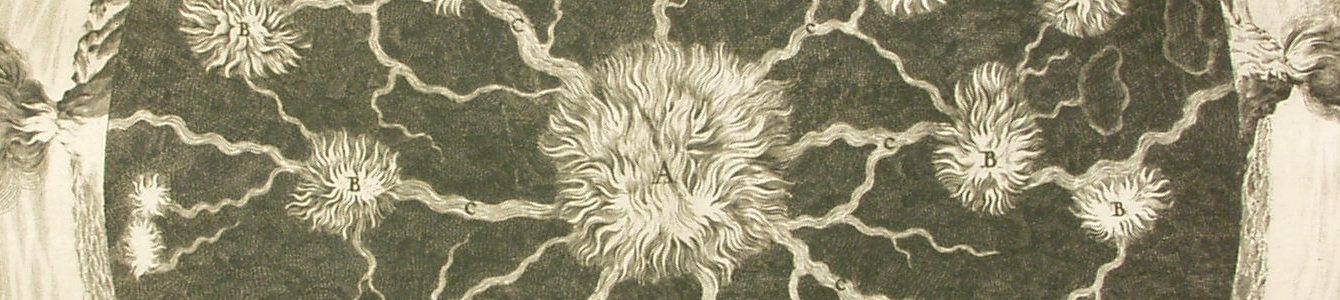

Tra i pionieri in campo industriale è da ricordare il francese de Larderel che, a partire dal 1818, inaugurò l’utilizzo dei soffioni boraciferi in Toscana. I soffioni boraciferi verranno studiati poi scientificamente a fine XIX secolo da Raffaello Nasini, su sollecitazione di Piero Ginori Conti, interessato al loro sfruttamento industriale.

Nel 1847 il chimico piemontese Ascanio Sobrero (1812-1888), aggiungendo glicerina ad una miscela di acido nitrico e solforico, produsse per la prima volta la nitroglicerina di cui studiò sia le proprietà farmacologiche che esplosive. L’invenzione che avrebbe reso celebre Alfred Nobel, cui si deve il processo di elaborazione della dinamite, null’altro se non nitroglicerina stabilizzata, meno instabile e quindi trasportabile.

Figura centrale della chimica italiana del XIX secolo fu Stanislao Cannizzaro (1826-1910), che fece conoscere e sviluppò le teorie di Avogadro, ponendo le basi della classificazione periodica degli elementi.

In Italia alla fine del XIX secolo iniziò la produzione di concimi chimici: perfosfati, solfati di ammonio, sali potassici. Fra le aziende leader la Caffaro di Brescia. La più importante azienda chimica italiana è però stata la Montecatini: fondata nel 1888, assunse grande sviluppo sotto la direzione di Guido Donegani (1877-1947), che ne fece l’azienda leader nella chimica industriale.

Dagli anni ’20 sino ai ’60-’70 del XIX secolo, l’Italia fu uno dei tre paesi con industria chimica più sviluppata per quantità e qualità.

Giacomo Fauser (1892 -1971) mise a punto la sintesi dell’ammoniaca con procedimento elettrolitico.

In epoca fascista, la chimica ebbe uno sviluppo importante poiché vigeva l’autarchia, ovvero l’indipendenza nazionale dal punto di vista delle materie. Dovuta a una sanzione della Società delle Nazioni dopo i fatti della guerra d’Etiopia, l’autarchia fu il modo in cui il regime fascista propagandò una presunta volontà dell’Italia di procedere con le proprie forze.

Negli anni Trenta la Montecatini e la Snia Viscosa dominarono la ricerca ed il mercato della chimica: la prima per le piriti, gli anticrittogamici, l’acido solforico e cloridrico, la seconda per la cellulosa da piante nazionali, la gomma sintetica e le fibre artificiali e per quelle derivate da prodotti naturali, come il “Lanital”, ricavato dalla caseina ad opera del tecnico bresciano Antonio Ferretti.

Enrico Mattei (1906-1962), prima di essere presidente dell’Eni, lavorò all’Agip. Tentò di costruire una via alternativa per svincolarsi dalle sette sorelle più potenti mondiali. Cerco inoltre di stipulare degli accordi con le realtà mediorientali e la Russia per degli approvvigionamenti petrolchimici ma, a causa di una mancanza di affiancamenti economici, questo progetto fallì. La morte di Mattei, avvenuta per lo schianto del proprio aereo privato, rimane ancora parzialmente avvolta nel mistero.

Giulio Natta (1903-1979) lavorò all’Edison ma anche al Politecnico di Milano. Fu insignito del premio Nobel per la chimica nel 1963, per la messa a punto di catalizzatori stereospecifici per la polimerizzazione stereochimica selettiva delle alfa-olefine, in particolare per la realizzazione del polipropilene isotattico.

Il polipropilene divenne celebre in Italia negli anni ’60, quando il comico Gino Bramieri apparve nella pubblicità del “Moplen” (commercializzato dalla Montecatini), la plastica dei casalinghi che sostituiva secchi di metallo, ma anche piatti e bicchieri di porcellana e vetro.