Con l’avvento delle armi da fuoco, il profilo delle mura di cinta delle fortificazioni e del territorio circostante cambiò radicalmente: nacque il fronte bastionato, progettato e costruito a seguito di precisi studi geometrici, in relazione alle traiettorie dei proiettili.

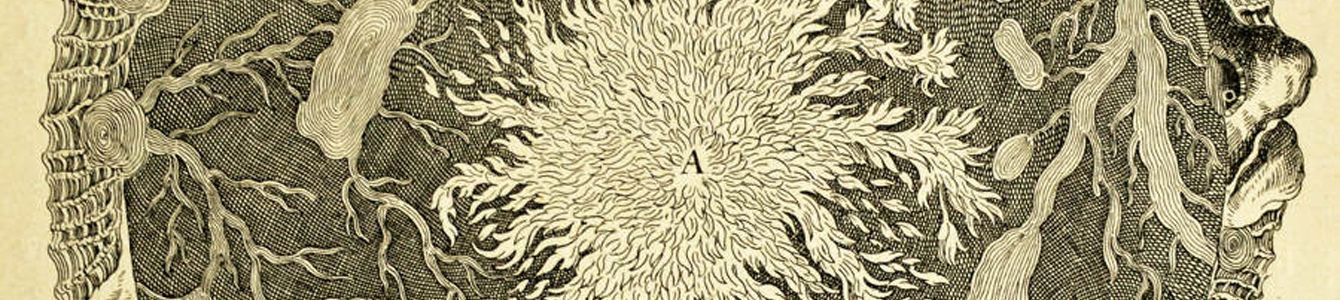

Con l’avvento delle armi da fuoco, il profilo delle mura di cinta delle fortificazioni e del territorio circostante cambiò radicalmente: nacque il fronte bastionato, progettato e costruito a seguito di precisi studi geometrici, in relazione alle traiettorie dei proiettili.La fortezza del xvi secolo si presentava quindi più ribassata di quella medievale, e con angoli tra le mura adiacenti tali da far rimbalzare dalle superfici delle torri angolari i proiettili sparati. Essa era edificata con la tipica “forma a stella”: a seguito di studi geometrici, si era infatti notato che le vecchie torri circolari soffrivano della presenza di un angolo cieco, ovvero di una zona non visibile e non esposta al fuoco difensivo delle torri laterali. La base circolare delle torri (come in quelle della fortezza di Forlì, 1464) quindi evolve sempre più verso una forma triangolare (come nella fortezza di Barletta, 1537), o meglio “a picca”, dove i lati dei triangoli risultavano coincidenti con la traiettoria dell’artiglieria posta sulle due torri laterali, intersecandosi con il vertice del triangolo, ed eliminando così gli angoli ciechi.

Lo sviluppo di una fortificazione che risultasse efficiente non solo nel piano, ma anche in presenza di dislivelli altimetrici fu un problema risolto dalle tecniche di geometria proiettiva, facendo variare l’angolo di incidenza tra le torri proporzionalmente al dislivello del terreno.

Tra gli ingegneri militari più importanti del tempo ricordiamo Sébastien le Prestre Vauban (1633-1707), che nell’ultimo terzo del xvii secolo e il primo decennio del xviii lavorò alle fortificazioni di oltre 200 città, progettando l’edificazione di una quarantina di fortezze e porti militari, per lo più in Francia, ma con una eco che lo rese famoso in tutta l’Europa.

Parallelamente all’evoluzione del fronte bastionato, crebbero e si evolsero anche le tecniche d’assedio secondo criteri scientifici: gli “assedi scientifici” furono infatti teorizzati e poi efficacemente sperimentati più volte.

Si tratta di applicazioni matematizzate delle migliori strategie di assedio e di attacco alle fortificazioni: tra le principali, il metodo delle parallele (teorizzato da Vauban) prevedeva l’avanzamento delle linee attaccanti per trincee parallele a quelle delle mura.

In presenza di strutture di difesa come i forti bastionati di Vauban, l’attacco diretto diventava molto difficile. Spesso l’assedio risultava vincente non già militarmente, ma per l’impossibilità da parte degli assediati di sostentarsi, per la mancanza di approvvigionamenti.

Altra possibilità era il passaggio per linee sotterranee: si scavavano trincee radiali, avanzando sottoterra alla profondità di anche 6 metri, che si avvicinavano alla città sotto assedio: una volta raggiunta una distanza ottimale, il nemico avrebbe piazzato dell’esplosivo sotto le mura di cinta. Ci si difendeva di conseguenza, costruendo una galleria alla profondità più probabile alla quale avrebbe potuto incrociare quella nemica. La galleria aveva forma circolare, ciò che tra l’altro, le consentiva di sopportare bene un’interruzione, trattandosi di una rete ad anello; infine, le gallerie radiali di servizio venivano costruite al di sopra della rete circolare (sempre sottoterra), per meglio difendersi dalle esplosioni, con una pendenza negativa rispetto al forte.

Con il potenziamento delle artiglierie fu necessario estendere la linea di difesa delle città oltre il raggio consueto: le mura difensive si allontanavano sempre di più, e venivano costruite numerose fortezze oltre le mura di confine (come visibile nella Parigi attorno alla metà del xix secolo: essa era circondata da una serie di fortezze che controllavano la campagna intorno alla città).

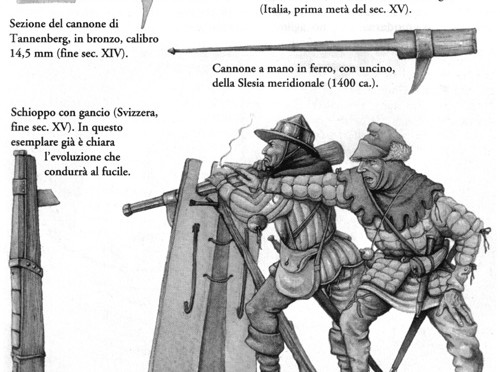

Anche questa strategia si rivelò insufficiente quando la gittata delle artiglierie cominciò a superare le decine di chilometri, così come anche il bastione si rivelò presto oramai inutile e superato, quasi anacronistico, di fronte ai progressi del tempo: perfezionamento delle armi da fuoco e degli esplosivi chimici, definizione sempre migliore della forma ogivale dei proiettili che ne ottimizzava l’uso, sviluppo ed evoluzione delle tecniche metallurgiche di fusione, ovvero qualità sempre più alta delle artiglierie. Il bastione diventò inutile.

Durante la Prima guerra mondiale si ebbe un ritorno del valore deterrente dell’arma da fuoco: Parisgeschütz (ossia “Cannone di Parigi”, o ancora “Cannone Kaiser Guglielmo”) fu il nome dato dall’esercito tedesco al più grande pezzo d’artiglieria usato durante la Prima guerra mondiale; tuttavia, per via della piccola carica esplosiva, i colpi di questo cannone non procuravano grandi danni ed oltretutto la canna doveva essere sostituita spesso, mentre la precisione del tiro era così scarsa che i bersagli avevano le dimensioni di una città. L’obiettivo dei tedeschi era però disporre di un’arma psicologica per intaccare il morale dei parigini, dal momento che un’arma così potente e al tempo stesso così imprevedibile avrebbe avuto solo l’effetto di generare “terrore” tra la popolazione civile e non.

L’obiettivo dei tedeschi era però disporre di un’arma psicologica per intaccare il morale dei parigini, dal momento che un’arma così potente e al tempo stesso così imprevedibile avrebbe avuto solo l’effetto di generare “terrore” tra la popolazione civile e non.

Il simbolo contemporaneo della fine dell’era del fronte bastionato è la Linea Maginot, edificata nel 1928 dai francesi: essa si rifaceva al paradigma bellico della Grande Guerra, il conflitto di trincea per antonomasia, risultando assolutamente fuori luogo nel corso della Seconda guerra mondiale, che si rivelerà poi una guerra di movimento. Fu installata negli stessi luoghi che videro la guerra di trincea durante il primo conflitto mondiale, ed essa infatti non si rese mai effettivamente utile, dal momento che i tedeschi la aggirarono.